Evolution des métriques de visibilité web à l’ère de l’IA

6 mai 2025À l’heure où l’intelligence artificielle (IA) redéfinit les paradigmes du web, la question de la visibilité en ligne n’a jamais été aussi cruciale. Les moteurs de recherche, Google en tête, s’appuient de plus en plus sur des algorithmes dopés à l’IA pour classer les contenus. Dans ce contexte, le référencement naturel (SEO) reste-t-il le pilier incontournable qu’il était ? Ou faut-il repenser les stratégies pour perdurer dans un écosystème numérique en mutation ? Cet article explore l’évolution du SEO, prônant une approche prudente centrée sur la désoptimisation pour maintenir une présence durable et naturelle en ligne.

L’IA au cœur des moteurs de recherche : une révolution en marche

Les moteurs de recherche ne se contentent plus d’analyser des mots-clés ou des liens. Grâce à des algorithmes comme BERT (Bidirectional Encoder Representations from Transformers) ou MUM (Multitask Unified Model) pour Google, ils analysent désormais le contexte, l’intention des utilisateurs et même la qualité intrinsèque d’un contenu.

Selon un article de Search Engine Journal publié en 2024, l’IA permet aux moteurs de recherche de prioriser les contenus qui répondent précisément aux besoins des utilisateurs, reléguant les techniques SEO traditionnelles – comme la répétition à l’excès de mots-clés – à des pratiques obsolètes et risquées (source : Search Engine Journal, 2024).

Dans ce paysage, les sites web doivent s’adapter à une exigence croissante de pertinence et d’authenticité. Les algorithmes, capables d’identifier des schémas artificiels, pénalisent les stratégies trop agressives. C’est ici qu’intervient la notion de désoptimisation, une approche qui vise à réduire les pratiques SEO excessives pour présenter un profil plus naturel.

La désoptimisation : une stratégie de prudence pour durer

La désoptimisation, comme expliquée sur le site spécialisé desoptimisation.com, consiste à alléger les actions SEO trop marquées qui pourraient être interprétées comme manipulatrices par les algorithmes. Cela inclut la lisibilité des rédactionnels qui doivent être compréhensibles et agréables à lire (donc pas truffés de mots-clés toutes les deux phrases), ou la simplification de structures (comme la conception de cocon ou silo sémantique) conçues uniquement pour plaire aux moteurs. L’objectif ? Offrir un contenu qui privilégie l’expérience utilisateur (UX) tout en restant visible.

Cette approche s’inscrit dans une logique long termiste. En effet, Google a renforcé ses mises à jour algorithmiques, comme l’update « Helpful Content » de 2024, qui récompense les contenus authentiques et pénalise ceux qui semblent artificiellement optimisés (source : Google Search Central, 2023). Les sites qui adoptent une stratégie de désoptimisation réduisent ainsi le risque de sanctions tout en consolidant leur crédibilité auprès des utilisateurs et des moteurs. A l’inverse, les sites qui abusaient de techniques SEO ont été lourdement pénalisés. Dans le secteur du tourisme, ce sont les blogs de voyages qui ont été particulièrement visés, jugés non seulement trompeurs par cette mise à jour Google, mais également inutiles car diffusant tous plus ou moins les même contenus, donc n’apportant aucune valeur ajoutée. Nombre d’entre eux ont tout simplement disparu des pages de résultats et sont tombés dans l’oubli. Depuis, la plupart ont été abandonnés.

Le SEO n’est pas mort, mais il doit évoluer

Dire que le SEO est devenu inutile serait une erreur. Il reste un levier essentiel pour structurer un site, améliorer son accès aux robots des moteurs tout en fluidifiant leur parcours et répondre aux attentes des utilisateurs. Cependant, son application doit être repensée. Une étude de Moz en 2024 souligne que les facteurs comme la qualité du contenu, l’autorité du domaine et l’expérience utilisateur surpassent désormais les techniques, telles que l’optimisation des balises meta ou la densité de mots-clés (source : Moz, 2024).

L’ère de l’IA impose donc une approche équilibrée : un SEO « doux » qui respecte les directives des moteurs tout en évitant les excès. Par exemple, produire des contenus riches, bien structurés et centrés sur l’utilisateur, tout en surveillant les signaux d’alerte (comme un taux de rebond élevé) devient plus stratégique que jamais.

La désoptimisation, en complément, permet de polir cette stratégie pour qu’elle paraisse organique.

Les risques de l’inaction ou de l’excès

Ne rien faire n’est pas une option. Les sites qui négligent leur visibilité risquent de disparaître dans les tréfonds des résultats de recherche, où 75 % des clics se concentrent sur la première page (source : Backlinko, 2023).

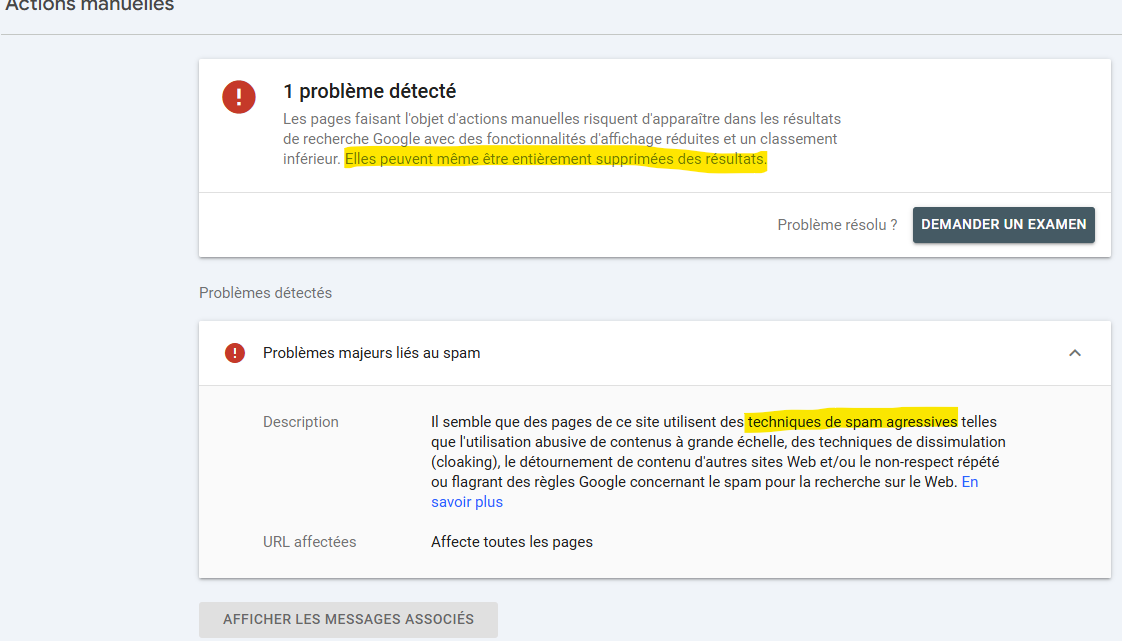

À l’inverse, une optimisation agressive peut entraîner des pénalités algorithmiques ou manuelles.

La prudence s’impose donc comme une boussole. En adoptant une stratégie de désoptimisation, les entreprises peuvent non seulement se protéger contre les aléas des mises à jour algorithmiques, mais aussi construire une présence en ligne durable, alignée sur les attentes des utilisateurs et des moteurs.

SEO : un équilibre à trouver pour l’avenir

À l’ère de l’IA, le SEO n’a pas perdu de son importance, mais il a changé de visage. Les moteurs de recherche, plus intelligents, exigent des contenus authentiques et des stratégies subtiles. La désoptimisation, comme prônée par des experts tels que ceux de desoptimisation.com, apparaît comme une réponse pragmatique pour naviguer dans cet environnement complexe. En misant sur la qualité, l’authenticité et une optimisation mesurée et naturelle, les sites web peuvent espérer non seulement survivre, mais prospérer dans un écosystème numérique en constante évolution.

En somme, le SEO reste un outil puissant si manié avec précaution en plaçant l’utilisateur au cœur de chaque décision, comme Google le recommande dans ses bonnes pratiques ici https://developers.google.com/search/docs/fundamentals/creating-helpful-content?hl=fr